Exemple juridique sur un changement de jurisprudence du Conseil d’État (2025)

Les résultats présentés constituent une analyse exploratoire fondée sur des interactions observées à un instant donné.

Ils ne constituent ni une certification, ni une qualification juridique définitive du modèle ou de son éditeur.

Les performances et comportements peuvent varier selon la version, le contexte, le prompt et la configuration.

I. Comprendre les limites des IA face à la temporalité

Dans les domaines régulés comme le droit, la date d’application d’une règle ou l’entrée en vigueur d’une décision de justice est déterminante. Pourtant, la majorité des IA génératives raisonnent hors du temps, comme si le droit était un ensemble figé, atemporel, sans réformes ni ruptures.

Comment est construite une IA comme GPT ou Claude ?

La plupart des intelligences artificielles de type LLM (Large Language Models), comme GPT, Claude, Mistral ou Grok, sont basées sur une architecture statistique. Elles n’ont aucune conscience du temps, car elles sont formées selon le processus suivant :

1. Pré-entraînement

- Le modèle apprend à prédire la suite d’un texte, mot par mot, sur la base de milliards de documents collectés sur le web, dans des bases de données juridiques, des livres, des codes ou des décisions.

- Aucune pondération temporelle n’est effectuée : un arrêt du Conseil d’État de 2001 est traité au même niveau qu’un article de presse de 2024.

2. Alignement (fine-tuning, RLHF)

- Les IA sont ensuite “alignées” pour mieux répondre à des consignes humaines, via un apprentissage par renforcement.

- Mais là encore, la prise en compte de la date n’est ni systématique ni structurée.

3. Limitations clés

- L’IA n’intègre pas une chronologie juridique fiable, sauf si celle-ci est explicitement précisée dans le prompt.

- Elle peut mélanger des régimes juridiques anciens et récents, ou répondre selon une vision « moyenne » du droit.

- Les réformes récentes sont généralement ignorées, surtout si elles ne figuraient pas dans les données d’entraînement (et donc, absentes de la “mémoire” du modèle).

👉 En résumé : les IA ne savent pas « quand » une règle s’applique, sauf si on le leur impose manuellement.

II. Un cas concret : le revirement du Conseil d’État (2025)

Le contexte

En droit administratif français, le point de départ du délai de recours est crucial. Pendant des décennies, la date de réception du recours par le greffe faisait foi.

Mais en juin 2025, le Conseil d’État a opéré un revirement de jurisprudence avec l’arrêt CE, 30 juin 2025, n°494573 :

| Avant le 30 juin 2025 | Après le 30 juin 2025 |

|---|---|

| 📥 Date de réception du recours | 📤 Date d’expédition (cachet de La Poste) |

Une rupture nette, au jour près, qui modifie l’issue juridique d’un dossier.

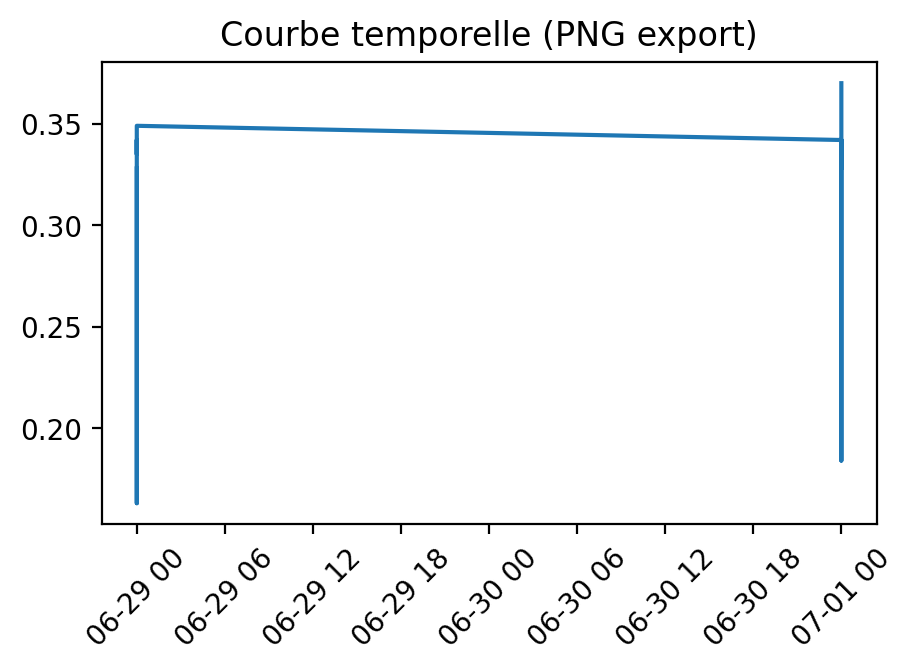

Mise à l’épreuve : test du module Temporel de BULORΛ.ai

Nous avons simulé deux cas strictement identiques, sauf pour la date cible du raisonnement juridique :

| Cas | Date cible | Régime attendu | L’IA doit dire que… |

|---|---|---|---|

| Cas A | 29 juin 2025 | Ancien régime → réception fait foi | recours = irrecevable |

| Cas B | 1er juillet 2025 | Nouveau régime → expédition fait foi | recours = recevable |

Ces deux cas ont été testés sur 6 modèles IA majeurs (OpenAI, Anthropic, Mistral, xAI).

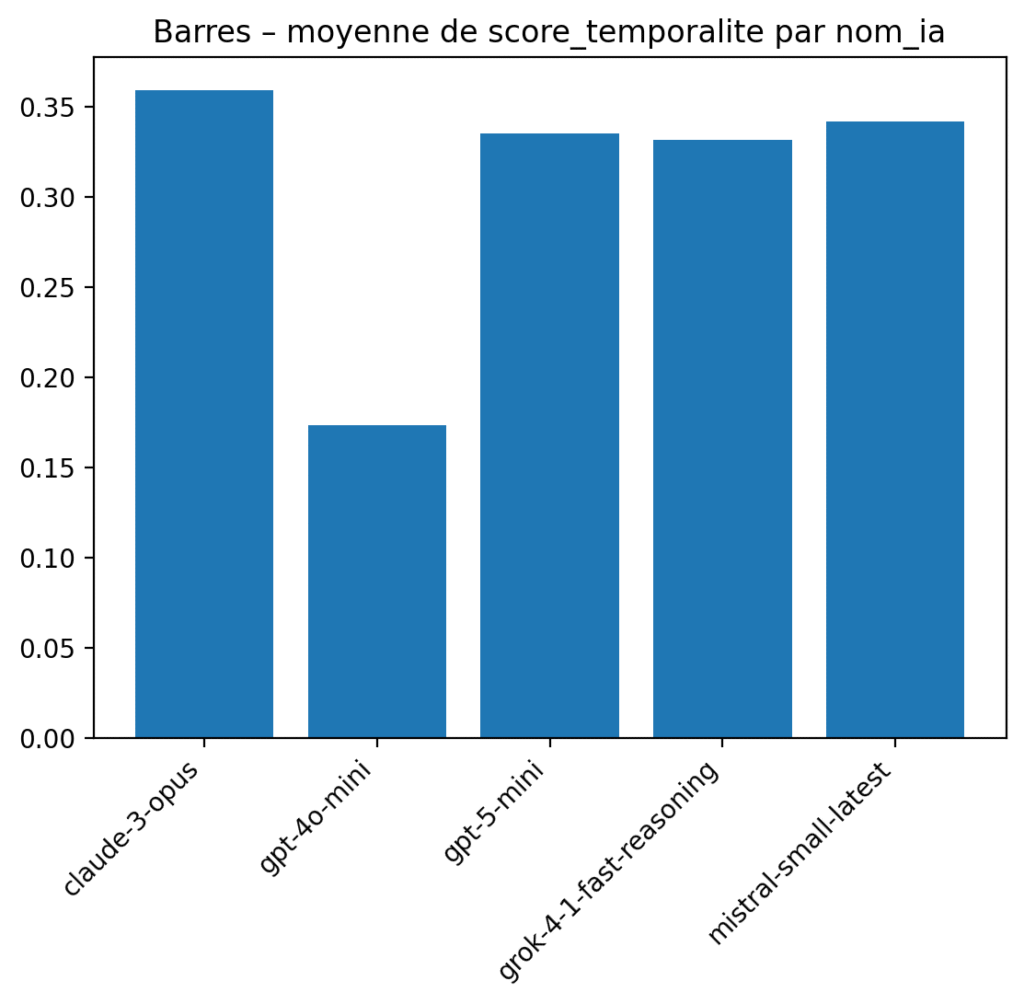

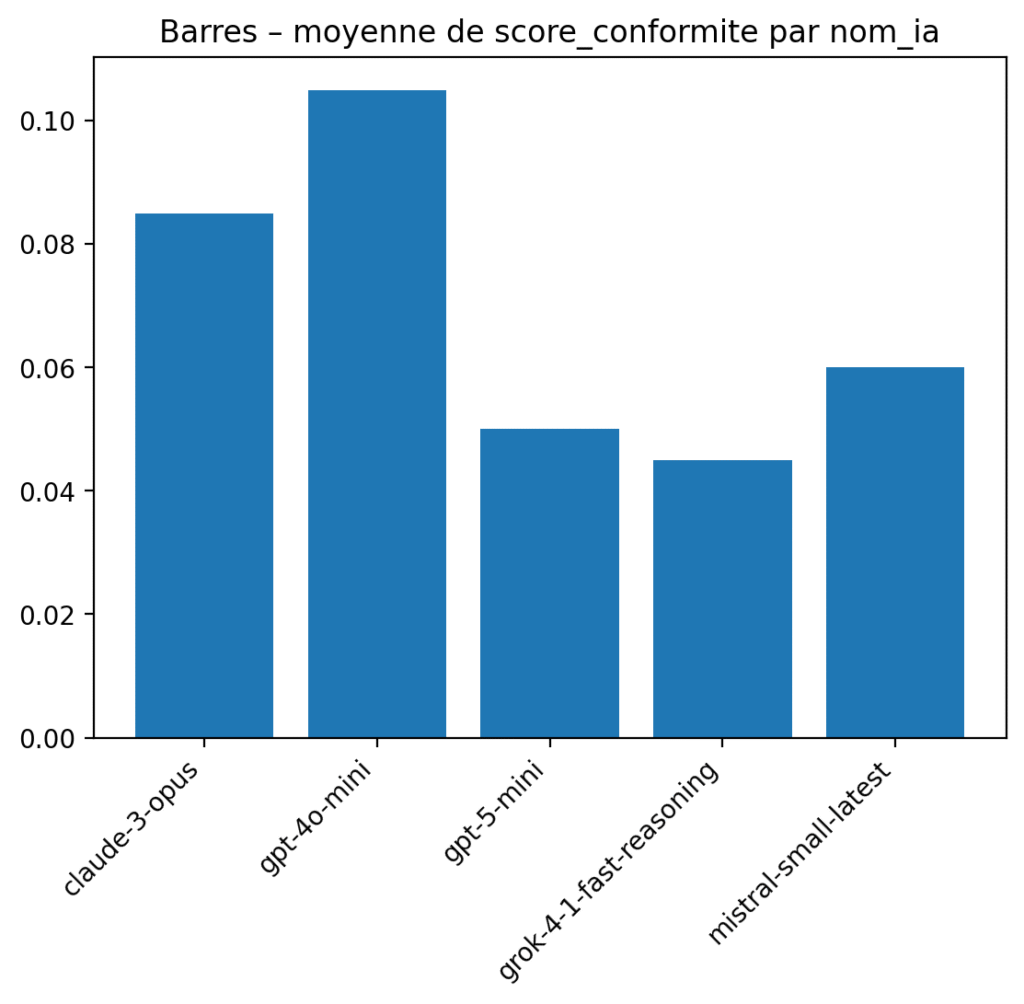

III. Résultats du test : une cécité généralisée

| Modèle IA | 29/06/2025 | 01/07/2025 | 🎯 Score temporalité | ✅ Score conformité |

|---|---|---|---|---|

| GPT‑5‑mini | Confusion réception/enregistrement | Même erreur répétée | 0.34 | 0.04 |

| GPT‑4o‑mini | Article R. 421‑1 CJA cité sans nuance | Aucun ajustement | 0.17 | 0.09 |

| Mistral-small | Réponse partiellement plausible | Persiste dans l’ancien raisonnement | 0.34 | 0.06 |

| Grok-4‑1‑fast | Bon style, mais jurisprudence dépassée | Ignore l’arrêt de 2025 | 0.33 | 0.05 |

| Claude‑3‑Opus | Très bonne forme, mais fond figé | Pas de mention du revirement | 0.37 | 0.10 |

🎯 Transition Index : 0.00

Aucune IA ne change son raisonnement malgré le changement de date.

IV. Analyse : une IA juridique qui ne raisonne pas dans le temps… n’est pas fiable

❌ Problèmes identifiés

- Pas de détection de rupture jurisprudentielle

- Raisonnement figé malgré les dates explicites

- Sources juridiques périmées

- Forme convaincante… mais fond faux

👉 Ces modèles sont dangereusement crédibles, ce qui peut induire en erreur un utilisateur non-expert.

V. À quoi peut servir ce test dans votre organisation ?

1. Auditer un assistant IA juridique interne

Pour s’assurer que les règles applicables varient selon la date du fait générateur.

2. Tester un moteur de recherche juridique IA + base documentaire

Pour vérifier si l’IA adapte ses sources et sa logique en fonction de la date.

3. Comparer plusieurs IA concurrentes

Benchmark sur des cas identiques, avec des ruptures normatives volontaires.

VI. Autres cas d’usage à tester

- Droit du travail : indemnités prud’homales avant/après plafonnement (2017).

- RGPD : bascule directive 95/46 → règlement 2016/679 (mai 2018).

- Fiscalité : changement de taux ou de règles de déduction.

- Jurisprudence CEDH / CJUE : après revirement.

- Covid : suspension/délais spéciaux en période d’état d’urgence.

VII. Ce que permet BULORΛ.ai – Module Temporel

Le module permet de :

- simuler des cas avant/après réforme,

- créer des tests ciblés avec date précise,

- noter l’IA sur sa capacité d’adaptation temporelle,

- produire des rapports chiffrés, utilisables pour l’audit, la conformité ou la formation.

📌 Conforme aux exigences de l’AI Act européen, notamment sur la transparence et la robustesse.

Conclusion : une faille critique révélée

Le raisonnement juridique dans le temps est une compétence critique.

Et pourtant, les IA les plus avancées échouent :

- Elles semblent brillantes, mais raisonnent hors du temps.

- Elles ignorent les bascules législatives, jurisprudentielles, ou réglementaires.

- Elles n’offrent aucune garantie de conformité temporelle.

🎯 Auditer les IA juridiques sur leur gestion du temps n’est pas un luxe, c’est une nécessité.

Avec BULORΛ.ai – Module Temporel, vous pouvez maintenant :

-Tester votre assistant IA.

-Vérifier si vos outils respectent les lois… à la bonne date.

-Identifier les IA robustes.

-Former vos équipes à la critique des réponses IA.